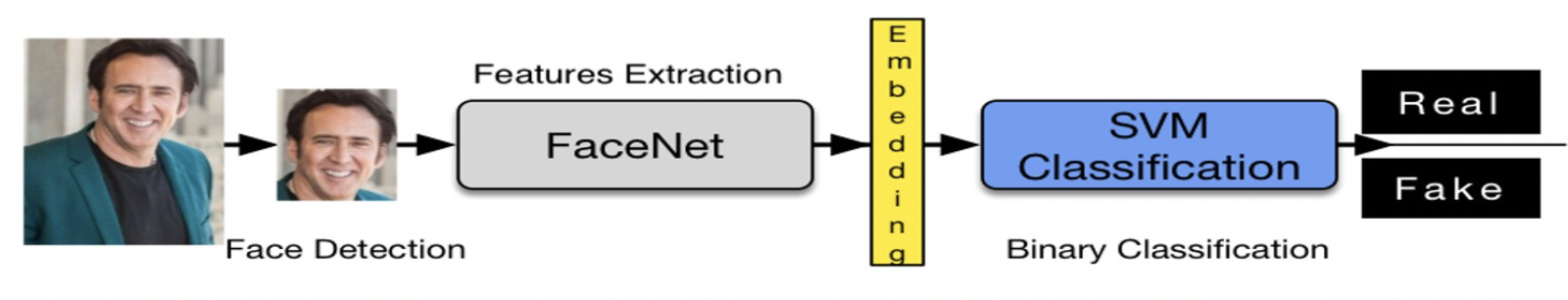

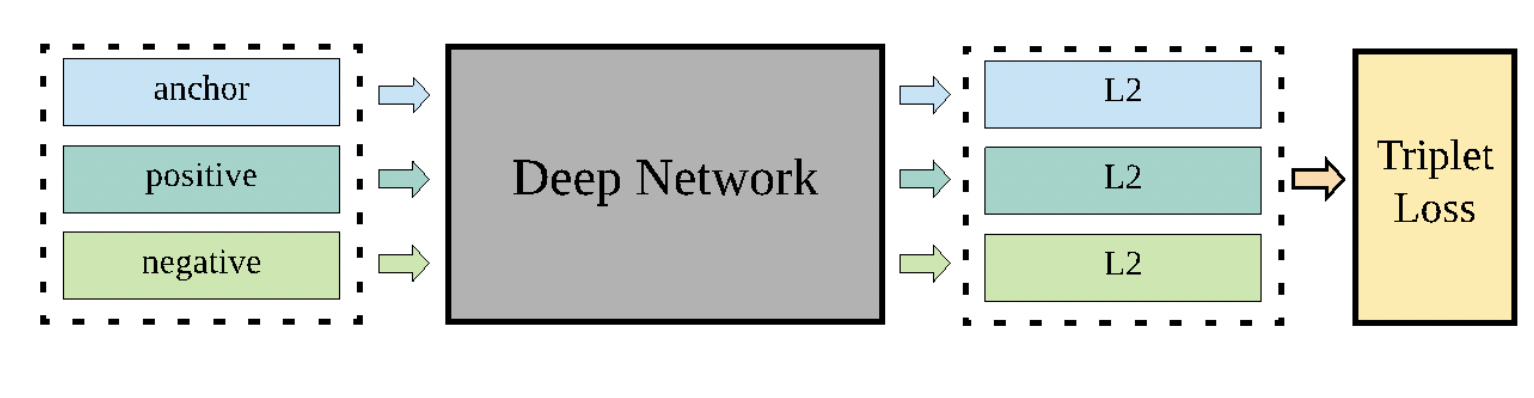

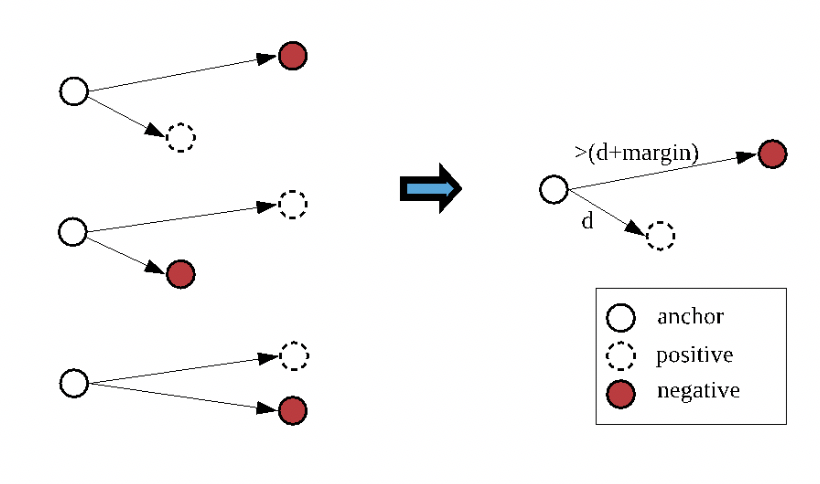

当地时间 8 月26 日- 30日,欧洲顶级信息安全会议HITB(HACK IN THE BOX)GSEC 2019在新加坡召开。百度安全带来的议题“连中三元”,成为本届议题入选最多的国内企业,刷新历史纪录,再一次证明百度安全在AI安全攻防领域的领先地位。HITB(HACK IN THEBOX)是欧洲最具影响力的信息安全峰会,每年在荷兰阿姆斯特丹及新加坡举办,迄今已有16年历史,是一年一度全世界顶尖信息安全研究员及大咖共同分享前沿课题及攻防技术的盛会。图| 百度安全携AI安全三大议题亮相HITB GSEC 2019Deepfakes“换脸术”的安全性时下俨然成为舆论的焦点,不仅仅在于其早已超出了娱乐的范畴、被技术滥用对知名人士造成版权及隐私的困扰,同时也因AI换脸黑产的不断蔓延,引发了企业及监管部门的关注。针对视频内容真实性的技术检测及工具共享迫在眉睫。本届HITB上,百度安全研究员WANG YANG、DOU GOODMAN、JAY XIONG 带来的最新研究成果显示,基于深度学习卷积神经网络(CNN)可以有效针对AI换脸视频进行“打假”。报告中提及两类基于CNN的检测方式,无论是基于简单CNN构建的探测器对于图像低层次特征(low-level feature)的提取与分析,还是利用FaceNet作为人脸特征的向量提取器,继而针对SVM二分类器(binary classification)进行机器学习,在检测AI换脸(Deepfakes)、人脸融合(Face Merge)中均有可观的表现,分辨真假的准确率分别高达99%、94%。值得指出的是,百度安全研究员将在既往检测方式中表现不佳的经压缩放、过曝、剪切、翻转后的图像纳入模型训练的范畴,显著提升检测模型的鲁棒性。同时,为向业内分享百度在人脸识别检测的研究成果,促进多方部门开展联合开发及测量评估,百度安全目前已开源业内首个AI换脸检测工具,点击文末“阅读原文”查看。不仅是“假脸”鉴别,还有虚假新闻的治理。社交媒体裹挟的巨大流量、内容生产及传播方式,使得假新闻的滋生及扩散变得轻而易举,如被蓄意操控利用,后果难以估量。当下国内外各大社交平台纷纷加强人工在内容审核中的权重,这是辨别信息真伪的好方法,但在某些特殊场景下也会力不从心。在特征识别、身份验证、归因分类等领域,人工智能正在发挥关键作用,从诸多看似错综复杂且毫无关联的关系中捕捉关系脉络,譬如通过文本特征(词库、词频、陈述结构、语气风格甚至标点)的分析,定位到匿名作者——是的,通常情况下,他们为掩盖身份而选择了匿名。受FaceNet在人脸特征识别、验证、分类等领域广泛应用的启发,本届HITB上,百度安全研究员ZHONGHOU LV、DOU GOODMAN利用深度神经网络,将提取的文本特征向量映射到欧几里德空间的球形表面中,最终通过欧几里德距离表示文本相似性:同一作者的文本距离较短,不同作者的文本距离较远。过程中,百度安全研究员创新性的引入TripletLoss(三元组损失,深度学习中的一种损失函数,用于训练差异性较小的样本)进行机器学习,且引入随机选择(Random Selection)、动态选择(Dynamic Selection)策略,显著提升检测精度和效率。结果表明,上述方法相较此前学术界基于线性空间的研究,尤其在作者数量庞大的情况下,表现出良好的性能。深度学习模型容易受到对抗样本的攻击,这在业内已不是新鲜事。对图像数据叠加人类难以通过感官辨识到的细微扰动,就可以“欺骗”模型,指鹿为马,甚至无中生有。业内将这种影响AI决策边界的细微扰动称之为“对抗样本”(Adversarial ExampleAttack)。然而,通过精确数据篡改可以达到完美欺骗机器识别的数字世界攻击效果,在实际物理环境的诸多限制之下,往往会失去作⽤——欺骗探测器可不是件容易事。继百度安全在Blackhat Europe 2018上首次验证“在物理世界中,对抗样本在机器识别领域是⼀个实际存在的威胁”之后,在本届HITB上,百度安全研究员JAY XIONG、WANG YANG、DOU GOODMAN借鉴训练深度神经网络的思路,在物理世界生成对抗样本,成功欺骗目标检测器。无论是针对Deepfakes“换脸术”的AI打假,还是追踪虚假新闻,均属于模型攻击检测的范畴。目前业界对于AI模型安全的思路大多聚焦于“攻”,关注于对抗样本的生成技术,而无法对模型安全性进行检测。技术一小步,从“攻”到“防”一大步。百度安全业内首创AdvBox对抗样本工具箱,针对AI算法模型提供安全性研究和解决方案,目前已应用于百度深度学习开源平台PaddlePaddle及当下主流深度学习平台,可高效地使用最新的生成方法构造对抗样本数据集用于对抗样本的特征统计、攻击全新的AI应用,加固业务AI模型,为模型安全性研究和应用提供重要的支持。百度安全的研究证明,人工智能时代不仅要面对曾经的云管端的安全问题,机器学习算法自身的安全性亦存在漏洞,存在现实威胁性。百度安全于2018年将首创的七大技术——KARMA系统自适应热修复、OpenRASP下一代云端安全防护系统、MesaLockLinux内存安全操作系统、MesaLink TLS下一代安全通信库、AdvBox对抗样本工具箱、MesaTEE下一代可信安全计算服务、HugeGraph大规模图数据库——开源汇成AI安全“七种武器”,全面解决云管端以及大数据和算法层面的一系列安全风险问题,实现由传统安全时代的强管理向AI时代的强技术支撑下的核心管理的转变,全面应对AI时代下层出不穷且日益复杂的生态安全问题及挑战。